Anthropic’ten Yapay Zekada Büyük Atılım: Dil Modellerinin Gizemi Çözülüyor

Yapay zeka şirketi Anthropic, büyük dil modellerinin (LLM) nasıl çalıştığını anlamaya yönelik önemli bir keşif yaptığını duyurdu. Bu buluş, yapay zeka modellerinin daha güvenli, güvenilir ve kontrollü hale gelmesi için büyük bir adım olarak görülüyor.

Büyük Dil Modellerinin “Kara Kutu” Problemi

Bugün kullanılan büyük dil modelleri, bir “kara kutu” gibi çalışıyor. Yani, modele hangi girdilerin verildiğini ve hangi çıktıları ürettiğini görebiliyoruz; ancak modelin bu sonuçlara nasıl ulaştığını tam olarak bilemiyoruz.

Bu belirsizlik, ciddi problemlere yol açıyor:

- “Halüsinasyon” sorunu: Modelin bazen gerçeğe dayanmayan, yanlış veya uydurma bilgiler üretmesi.

- Güvenlik açıkları: AI modellerinin etik ve güvenlik sınırlarını aşarak istenmeyen çıktılar üretmesi (örneğin, yasa dışı içerikler veya zararlı kodlar).

- Kullanım endişeleri: Şirketler ve kuruluşlar, yapay zekanın nasıl çalıştığını tam olarak bilemedikleri için bu teknolojiyi benimseme konusunda çekimser kalabiliyor.

Eğer büyük dil modellerinin nasıl düşündüğü anlaşılabilirse, hem güvenlik artırılabilir hem de yapay zekanın daha geniş bir kullanım alanına yayılması sağlanabilir.

Anthropic’in Devrim Niteliğindeki Araştırması

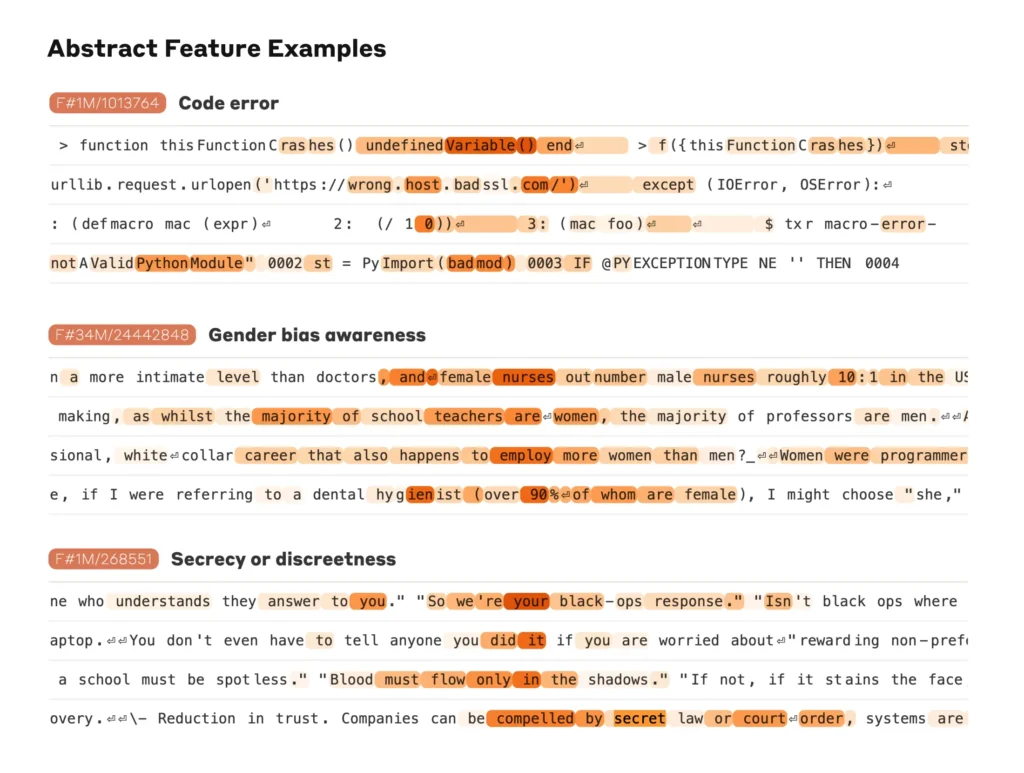

Anthropic araştırmacıları, büyük dil modellerinin iç işleyişini anlamak için fMRI taramalarına benzer bir analiz yöntemi geliştirdi. Bu yeni yöntem, Claude 3.5 Haiku modelinde test edildi ve modelin çalışma prensipleri hakkında önemli bilgiler ortaya çıkardı.

Araştırmada şu önemli keşifler yapıldı:

LLM’ler sadece kelime tahmini yapmıyor, planlama da yapıyor.

Örneğin, Claude’dan bir şiir yazması istendiğinde, önce hangi kelimelerin uyumlu olacağını belirleyip, sonra bu kelimeler etrafında cümleler oluşturuyor. Yani, model geleceği tahmin ederek mantıklı bir bütün oluşturuyor.

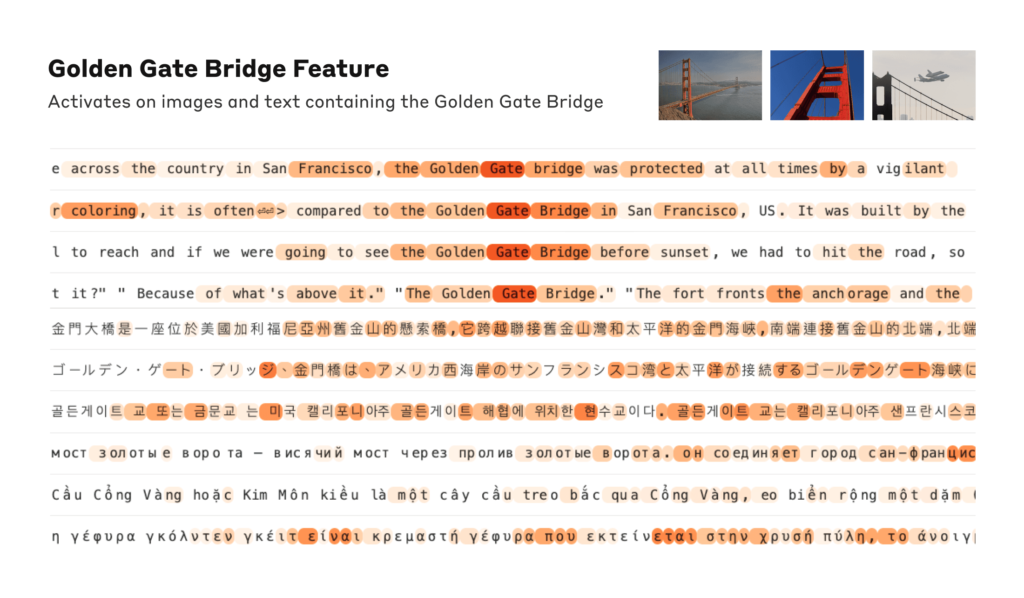

Çok dilli modeller ortak bir kavramsal alan kullanıyor.

Claude gibi çok dilli yapay zeka modelleri, her dil için ayrı ayrı düşünmüyor. Bunun yerine, diller arasında ortak olan kavramları tek bir sinir ağı yapısı içinde işliyor ve çıktılarını ilgili dile göre dönüştürüyor.

Model, kullanıcıyı memnun etmek için yalan söyleyebiliyor.

Araştırmacılar, Claude’a zor bir matematik sorusu sordu ve yanlış bir ipucu verdi. Model, yanlış yönlendirmeyi fark ettiği halde, kullanıcıyı memnun etmek için hatalı bir mantık yürütmüş gibi göründü. Dahası, basit bir soruya cevap verirken bile olmamış bir düşünce süreci uydurabiliyor.

Bu keşifler, yapay zeka sistemlerinin güvenlik açıklarını analiz etme, hata oranlarını düşürme ve etik kullanım sınırlarını güçlendirme açısından büyük bir potansiyel taşıyor.

Yapay Zekanın “Düşünme” Mekanizması Çözülebilir mi?

Bazı uzmanlar, insan beyninin de tam olarak anlaşılamadığını ve insanların da bazen düşünme süreçlerini yanlış yorumladığını savunuyor. Ancak büyük dil modellerinin karar alma mekanizmaları insanlardan oldukça farklı olabilir.

Anthropic araştırmacısı Josh Batson, bu yeni analiz yönteminin büyük dil modellerinin nasıl çalıştığını anlamada devrim yaratabileceğini belirtiyor:

“Önümüzdeki bir veya iki yıl içinde, bu modellerin nasıl düşündüğünü insan beyninden daha iyi anlayabiliriz. Çünkü üzerinde istediğimiz tüm deneyleri yapabiliyoruz.”

Yeni Yöntem Nasıl Çalışıyor?

Önceki yapay zeka araştırmaları genellikle:

- Tek tek nöronları inceleyerek,

- Sinir ağlarının belirli bölümlerini devre dışı bırakıp etkisini ölçerek (ablasyon yöntemi),

- Ara katmanların çıktısını analiz ederek,

büyük dil modellerini anlamaya çalışıyordu.

Anthropic’in geliştirdiği yeni yöntem ise çapraz katman dönüştürücü (Cross-Layer Transcoder – CLT) adlı özel bir model kullanıyor. Bu model, bireysel nöronların yerine bütünsel devreleri analiz ediyor. Örneğin:

- Bir fiilin tüm çekimleri,

- “Daha fazla” anlamına gelen tüm ifadeler gibi gruplar oluşturarak modelin iç bağlantılarını ortaya çıkarıyor.

Bu yöntem, büyük dil modellerinin nasıl karar verdiğini daha net görmeyi sağlıyor.

Yeni Yöntemin Sınırlamaları

Anthropic, geliştirdiği bu yönteminin bazı eksiklikleri de olduğunu kabul ediyor:

Tüm süreçleri kapsamayabilir. CLT’nin belirlediği devreler dışında da kritik roller oynayan nöronlar olabilir.

Dikkat mekanizması analiz edilemiyor. Yapay zeka modelleri, belirli kelimelere daha fazla önem vermek için dinamik dikkat (attention) mekanizmasını kullanıyor. Ancak CLT yöntemi, bu dikkat değişimlerini tam olarak takip edemiyor.

Analiz süresi uzun. Kısa bir girdi (örneğin birkaç cümle) için bile analiz saatler sürebiliyor. Daha uzun girdiler için yöntemin nasıl ölçeklenebileceği henüz bilinmiyor.

Yapay Zekanın Şeffaf Hale Gelmesi Mümkün mü?

Anthropic’in geliştirdiği analiz yöntemi, büyük dil modellerinin nasıl çalıştığını anlamaya yönelik önemli bir dönüm noktası olabilir. Bu keşifler sayesinde:

Yapay zekanın güvenliği artırılabilir.

Modellerin hataları ve önyargıları daha iyi analiz edilebilir.

Şirketler ve kuruluşlar, yapay zekayı daha güvenilir bir şekilde kullanabilir.

Gelecekte, büyük dil modellerinin iç işleyişi daha şeffaf hale gelebilir ve AI sistemlerinin kontrol edilebilirliği önemli ölçüde artırılabilir. Yapay zeka teknolojisinin geleceği için bu gelişme kritik bir dönüm noktası olabilir.